为什么要本地部署

快速回答: 通过 Ollama + Chatbox 可在 5 分钟内本地部署 DeepSeek R1,推荐 7B 版本(需 8GB+ 显存),支持完全离线运行,告别服务器繁忙。

DeepSeek 官方服务器经常出现「繁忙」状态,本地部署可以:

- 彻底解决排队等待问题

- 支持完全断网运行

- 保护敏感数据隐私

- 响应速度不受网络波动影响

部署方案概览

| 项目 | 说明 |

|---|---|

| 核心工具 | Ollama |

| 前端 UI | Chatbox AI |

| 推荐版本 | DeepSeek R1 7B |

| 模型大小 | 约 4.7 GB |

| 部署耗时 | 约 5 分钟 |

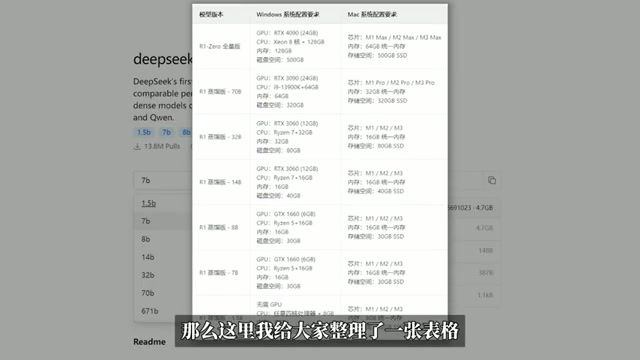

硬件配置要求

根据模型参数选择合适版本:

| 模型版本 | 显存要求 | 适用场景 |

|---|---|---|

| 1.5B | 4GB+ | 入门体验 |

| 7B | 8GB+ | 日常使用(推荐) |

| 14B | 16GB+ | 进阶需求 |

| 32B+ | 24GB+ | 专业级 |

建议:普通用户选择 7B 版本,兼顾性能与硬件要求。

第一步:安装 Ollama

下载安装

- 访问 Ollama 官网下载对应系统版本

- 支持 Windows、macOS、Linux

- 安装过程一路默认即可

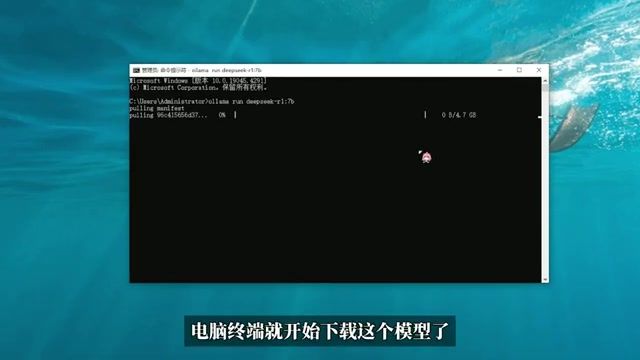

下载模型

打开终端(CMD / Terminal),执行命令:

ollama run deepseek-r1:7b等待模型下载完成:

下载完成后即可在终端内直接对话,但界面较为简陋。

第二步:配置 Chatbox UI

为获得更好的交互体验,推荐使用 Chatbox AI 作为前端。

安装 Chatbox

下载 Chatbox AI 客户端或使用网页版。

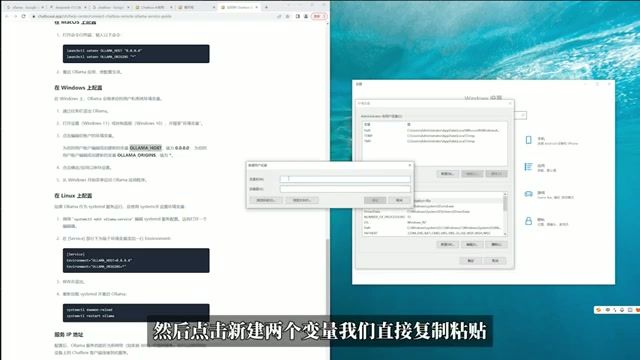

配置环境变量(Windows)

需要设置环境变量让 Chatbox 连接本地 Ollama:

操作步骤:

- 打开「控制面板」→「系统」→「高级系统设置」

- 点击「环境变量」

- 新建系统变量:

- 变量名:

OLLAMA_HOST - 变量值:

0.0.0.0

- 变量名:

- 重启 Ollama 服务

连接 Chatbox

- 打开 Chatbox

- 设置中选择「Ollama」作为 API 提供商

- 选择已下载的模型

- 开始对话

离线运行验证

本地部署的核心价值是离线可用:

完全禁用网络后,AI 依然能正常响应并展示思考链(Chain of Thought)。

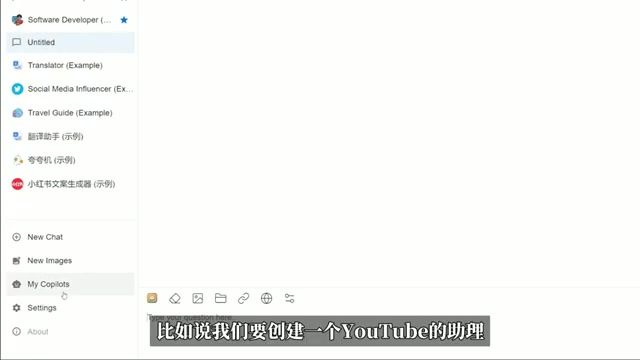

进阶:创建专属助理

Chatbox 支持预设 AI 身份,实现个性化定制:

可创建不同角色:

- 写作助手

- 代码审查员

- 翻译专家

- 学习导师

常见问题

运行速度慢

- 检查是否选择了过大的模型版本

- 确认显卡驱动是否最新

- 关闭其他占用显存的程序

Chatbox 连接失败

- 确认环境变量设置正确

- 重启 Ollama 服务

- 检查防火墙设置

模型下载中断

重新执行 ollama run 命令会自动续传。

适用人群

推荐本地部署:

- 受够了服务器繁忙的用户

- 需要处理敏感数据的用户

- 希望离线使用 AI 的用户

- 喜欢折腾的开发者和极客

不推荐:

- 硬件配置过低的用户

- 需要运行超大参数模型的用户(建议使用云端)

总结

通过 Ollama + Chatbox 的组合,普通用户也能轻松在本地运行 DeepSeek R1。整个过程无需编程知识,5 分钟即可完成配置,是平衡性能与易用性的最佳方案。

相关阅读

- AI Agent 技能指南 2026 - 了解更多 AI 应用场景

- OpenCode AI 编程指南 - AI 辅助编程工具推荐

- Agent Skills 深度解析 - AI 能力进阶探索

奈云Pro团队

认证专家网络技术专家

专注于网络加速技术研究与测评,为用户提供专业、客观的机场服务评测与使用指南。

网络加速技术机场服务测评客户端使用教程网络安全

本文为技术教程,请根据自身硬件条件选择合适的模型版本。